Immer strengere Qualitätsrichtlinien sowie ein erhöhter Kosten- und Zeitdruck führen zu verschärften Anforderungen an die Industrie. Ganz besonders betroffen sind dabei die Produktionseinheiten. Die Produktion ist daher mit völlig neuen Anforderungen bezüglich Schnelligkeit und Qualität konfrontiert. Daher ist eine lückenlose und wissenschaftlich fundierte Überwachung von Produktionsprozessen absolut notwendig. Dieser Prozess umfasst alle Aspekte der Produktion von der Prozessentwicklung bis hin zur Serienfertigung. Effiziente und effektive Beurteilungsverfahren sind deshalb auch wichtiger Bestandteil eines modern Quality Engineering Ansatzes. Quality Engineering beschäftigt sich neben der zentralen Frage nach einem einzuhaltenden Qualitätsniveau (Qualitätslevel, Prozessqualität) auch mit Verfahren zum Nachweis dieses Qualitätsniveaus. Ein weiteres Thema von Quality Engineering ist ausserdem die fortlaufendee Kontrolle des Qualitätsniveaus. In diesem Artikel möchten wir einen ersten Überblick über das Thema Quality Engineering geben. Dabei beschäftigen wir uns zunächst mit der Frage „Was ist Quality Engineering?“. Anschliessen werden die gebräuchlichsten statistischen Methoden verständlich (z.B. Messsystemanalysen, statistische Prozesskontrolle, statistische Versuchsplanung) vorgestellt.

Eine Zusammenstellung unserer Leistungen im Umfeld des Quality Engineering erläutern wir Ihnen gerne in einem persönlichen Gespräch. Gerne graben wir auch in ihren Datenschätzen neues Wissen für Sie aus!

Dieser Artikel beantwortet folgende Fragen zu Quality Engineering

- Was ist Quality Engineering?

- Welches Ziel verfolgt Quality Engineering?

- Welche statistischen Methoden des Quality Engineering gibt es?

- Warum sollten statistischen Methoden im Umfeld des Quality Engineering angewendet werden?

- Was sind die Zielsetzungen von Messsystemanalysen?

- In welchen Stufen eines Produkt-Lebenszyklus sollten diese Methoden verwendet werden?

- Was ist der Unterschied zwischen Konsumenten- und Produzenten Risiko?

Was ist Quality Engineering?

Allgemein gesprochen bezeichnet der Begriff „Quality Engineering“ eine Sammlung von Management Ansätzen und Methoden, die im Zusammenhang mit der Entwicklung, Optimierung, Produktion und Kontrolle von Prozessen und Produkten mit hohem Qualitätsniveau stehen. Beim angestrebten Qualitätsniveau spielen im Bereich der Industrie hierbei Zuverlässigkeit und Sicherheit der entwickelten Prozesse sowie der hergestellten Produkte eine entscheidende Rolle.

Gerne helfen wir Ihnen, ihre Datenbestände professionell auszuwerten und zeitnah, verständlich, kundenorientiert und effektiv die Ergebnisse ihres Quality Engineering Projekts zu präsentieren. Nehmen Sie Kontakt mit uns auf für eine kostenlose und unverbindliche Erstberatung!

Ziel des Quality Engineering – Sicherheit für Konsument und Produzent

Statistische Methoden sind ein wichtiger Bestandteil eines umfassenden Qualitätsmanagements. Dies umfasst alle Phasen eines Prozesslebenszyklus („Process Life Cycle“) ausgehend von Forschung und Entwicklung über die Routineproduktion bis hin zur finalen Qualitätsprüfung. Generell sollte man beim Qualitätsmanagement zwischen Konsumenten-Risiko (Consumer Risk) und Produzenten-Risiko (Producer Risk) unterscheiden. Auch wenn sich die statistischen Verfahren in beiden Bereichen nicht unterscheiden, ist eine saubere Trennung essenziell:

- Eine Bewertung des Konsumenten-Risikos findet in der Regel in der Entwicklungsphase statt. Dabei soll verhindert werden, dass nicht dem angestrebten Qualitätsniveau entsprechende Produkte und Prozesse weiter verfolgt werden im Sinne der Sicherheit für den Konsumenten nur akzeptable Produktqualität zu erhalten.

- Für dem angestrebten Qualitätsniveau entsprechende Produkte und Prozesse soll – meist nach erfolgreich bestandener Prozessvalidierung – in der Routineproduktion untersucht werden, ob dieses Qualitätsniveau weiterhin im Sinne der Sicherheit für den Produzenten eingehalten wird, um unnötige Prozessadjustierungen zu vermeiden

Generell können die im Weiteren dargestellten statistischen Methoden des Quality Engineering in Verbindung mit anderen Werkzeugen des Qualitätsmanagements (Total Quality Management (TQM), Quality-by-Design (QbD), Six-Sigma, FMEA) dann dazu dienen:

- Prozess- und Produktqualität wissenschaftlich abgesichert zu beurteilen

- Risiken von (Fehl-) Entscheidungen zu quantifizieren

- Erkenntnisse über Prozessverhalten und eventuelle Qualitätsveränderungen zu erlangen

- Massnahmen zur Fehleranalyse und Fehlerbeseitigung einzuleiten

- Ansätze zur weiteren Prozess- und Produktoptimierung zu identifizieren

„In God we trust – All others must bring Data“ – Statistische Methoden des Quality Engineering

„In God we trust – All others must bring Data“ – Diese Aussage des amerikanischen Physikers und Nobelpreisträgers R. A. Milikan trifft ganz besonders auf die Anwendung statistischer Methoden im Rahmen eines Quality Engineering Ansatzes zu. Eine möglichst lückenlose sowie belastbare Erhebung und Bereitstellung aussagekräftiger Qualitätsdaten ist die fundamentale Voraussetzung für eine korrekte und sinnvolle Qualitätsanalyse und -bewertung. Durch empirische Untersuchungen sollen Informationen über das Qualitätsniveau von Prozessen und Produkten erzeugt werden, die dann wiederum zur Optimierung des Qualitätsniveaus herangezogen werden.

Ganz konkret werden wir zuerst die wichtigsten statistischen Methoden des Quality Engineering kurz vorstellen und deren Grundprinzipien erläutern:

- Messsystemanalysen

- Statistische Versuchsplanung

- Prozessfähigkeitsanalysen

- Statistische Prozesskontrolle

- Stichprobenprüfung

Messsystemanalysen: Man misst eigentlich immer falsch …

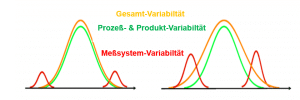

… man muss aber wissen wie viel! Unabdingbar für eine datenbasierte Qualitätsoptimierung ist eine genaue, zuverlässige und reproduzierbare Messbarkeit bzw. Quantifizierbarkeit der Qualität. Wichtig in diesem Zusammenhang ist es – wie auch einigen ISO Dokumenten beschrieben – festzuhalten, dass es nicht darum geht Qualität möglichst genau zu messen, sondern lediglich „genau genug“. Im Umfeld des Quality Engineering kann diese hinreichende Genauigkeit durch verschiedene Messsystemanalysen (Measurement System Analysis (MSA)) bewertet werden. Grundlage dieser Messsystemanalysen ist eine Zerlegung der beobachteten Gesamtprozessvariabilität in zwei Variabilitätskomponenten: Eine dieser Komponenten lässt sich allein auf das Produkt oder den Prozess zurückführen, die andere entspricht der Variabilität des Messsystems.

Ausgehend von dieser Variabilitätszerlegung der Messsystemanalysen werden in Industrienormen grundlegende Anforderung formuliert wie beispielsweise:

- Genauigkeit und Wiederholpräzision

- Linearität und Homogenität

- Stabilität

Statistische Messsystemanalysen haben dann in diesem Zusammenhang die beiden Hauptzielsetzungen:

- Zuverlässige Abschätzung der inhärenten Variabilität eines Messsystems als Bestandteil der Gesamtvariabilität eines Prozesses

- Bewertung der Fähigkeit eines Messsystems (Measurement System Capability) Qualität hinreichend genau bestimmen zu können

Statistische Versuchsplanung: Von Daten über das Modell zur optimalen Qualität

Im Hinblick auf eine optimale Produkt- und Prozessqualität ist ein fundamentales Produkt- und Prozessverständnis unerlässlich. Dies sollte unter anderem beinhalten:

- Identifikation aller qualitätskritischen Produkt- und Prozessparameter

- Optimale Einstellungen von Produkt- und Prozessparametern

- Limits und Spezifikationen dieser Parameter

- Festlegung des „Design Space“ als mehrdimensionalem Bereich der Produkt- und Prozessparameter, in dem ein akzeptables Qualitätsniveau garantiert werden kann

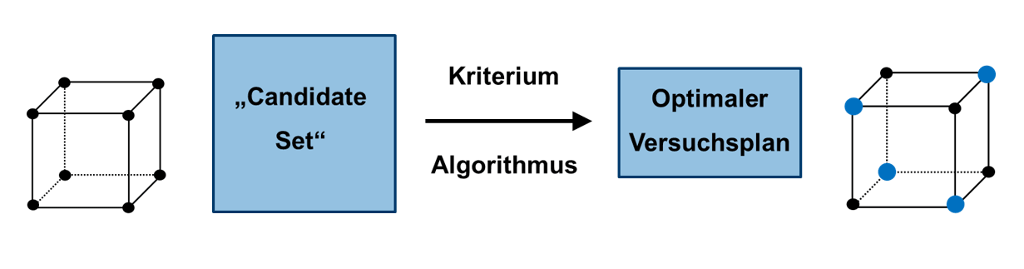

Die statistische Versuchsplanung (Design of Experiments (DoE)) als Methodensammlung des „Quality-by-Design“ Ansatzes ist insbesondere im Bereich der Forschung und Entwicklung eine wichtige Methodik diese Ziele zu erreichen. Geeignete experimentelle Bedingungen aus einer meist unübersehbar grossen Anzahl möglicher Experimente („Candidate Set“) werden hierzu für die empirische Ermittlung mathematischer Optimierungsmodelle ausgewählt.

Mit diesen Modellen ist es dann wiederum möglich komplexe Ursache-Wirkungsbeziehungen zu modellieren und somit zur wissenschaftlich fundierten und datengesteuerten Qualitätsoptimierung beizutragen. Zusammenfassend bietet die Anwendung statistischer Versuchsplanung im Bereich des Quality Engineering und des Quality-by-Design zur Qualitätsoptimierung die viele klare Vorteile im Vergleich zu unstrukturierten Ansätzen:

- Effiziente und effektive Methodik

- Apriori Planung von Ressourcen und Kosten

- Maximale Prozessinformation bei reduziertem Versuchsaufwand

- Systematische Ansätze zur Qualitätsoptimierung

- Zuverlässige Basis für nachfolgende Optimierungsstrategien

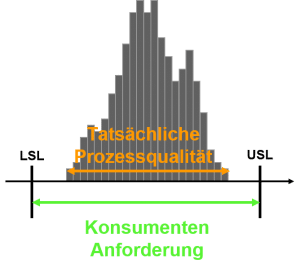

Prozessfähigkeit: „Hoffnung“ trifft auf „Realität“

Statistische Analysen zur Fähigkeit eines Prozesses sind im Grunde nichts anderes als Vergleiche der beobachteten, tatsächlichen Prozessqualität zu definierten Konsumentenanforderungen bezüglich des zu erreichenden Qualitätsniveaus. Diese Anforderungen werden dabei in aller Regel durch ein einzuhaltendes Spezifikationsintervall mit unterer Spezifikationsgrenze (Lower Specification Limit – USL) und oberer Spezifikationsgrenze (Upper Specification Limit – USL) charakterisiert.

Es hat sich inzwischen in fast allen Industriezweigen etabliert, dass Qualitätsniveau von Prozessen anhand verschiedener Kenngrössen zu bewerten. Diese Kenngrössen, werden auch Prozessfähigkeistindizes genannt und stammen ursprünglich aus dem Automobilbereich. Ein weithin gebräuchlicher Index Cp vergleicht dabei die beobachtete Prozessvariabilität, ausgedrückt durch die Prozessstandardabweichtung σ, mit dem einzuhaltenden Spezifikationsintervall [LSL, SL]. Die Fähigkeit eines Prozesses lässt sich also anschaulich definieren als:

\(Prozessf\ddot{a}higkeit=\frac{“Verbaucheranforderungen”}{“Tatsächliche\ Prozessqualit\ddot{a}t”}=\frac{“Hoffnung”}{“Realit\ddot{a}t”}=\frac{USL-LSL}{6\sigma}=C_{p}\)Untersuchungen zur Fähigkeit eines Prozesses werden in der Regel im Rahmen einer Prozessvalidierung durchgeführt und beinhalten dabei meist die folgenden Analysen:

- Abschätzung der Prozesslage und -variabilität sowie Durchschlupf- bzw. Defektrate

- Vergleich der geschätzten Prozessvariabilität und Durchschlupf- bzw. Defektrate mit definierten Qualitätsanforderungen

- Bewertung der Fähigkeit eines Prozesses, diese an ihn gestellten Anforderungen zu erfüllen

Statistische Prozesskontrolle: Kontrolliert oder nicht-kontrolliert – das ist hier die Frage

Allgemein umfasst die statistische Prozesskontrolle (Statistical Process Control (SPC)) eine Sammlung von Prinzipien und statistischen Werkzeugen, um

- Informationen über Prozesslage, Prozessvariabilität oder Defektraten zu erhalten

- Prozessveränderungen zu erkennen und ihnen entgegenzuwirken

- Prozessqualität zu analysieren, zu bewerten, zu überwachen und zu verbessern

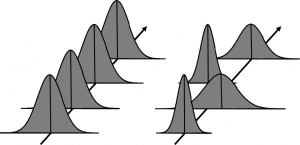

Die Unterschiede im Qualitätsniveau der hergestellten Einheiten bei industriellen Produktionsprozessen können dabei ganz generell auf zwei Variabilitätsursachen zurückgeführt werden:

- Prozessinhärente Variabilität („Common Cause Variability“): Besteht die Prozessvariabilität nur aus diesen Komponenten, befindet sich der Prozess in einem kontrollierten Zustand (Status: „In-Control-Status“)

- Prozessvariabilität, die speziellen Fehlern zugeordnet werden kann („Assignable / Special Cause Variability“): Hier befindet sich der Prozess im nicht kontrollierten Zustand („Out-of-Control-Status“)

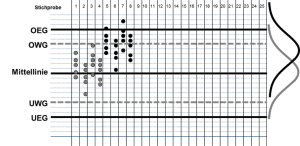

Hauptaufgabe der statistischen Prozesskontrolle ist es nun zwischen diesen beiden Prozesszuständen zu unterscheiden. Statistisches Hauptwerkzeug zu dieser Differenzierung von kontrollierten und nicht kontrollierten Prozessstatus sind die in den 1930er Jahren von W. A. Shewhart bei Bell Laboratories eingeführten Kontrollkarten oder Qualitätsregelkarten. Diese Karten bestehen im Wesentlichen aus einem Plot des chronologisch angeordneten Qualitätsniveaus über einen definierten Produktionszeitraum. Die eingezeichneten Mittellinien, Warn- und Kontrollgrenzen sind hier so konstruiert, dass die Verletzung einer der definierten Grenzen Hinweise auf mögliche Abweichungen von erwünschten kontrollierten Prozessstatus liefern.

Stichprobenprüfung: „So wenig Stichproben wie möglich“ aber auch „So viele Stichproben wie nötig“

Häufig bieten Prozesse keine Möglichkeit einer Totalkontrolle der produzierten Einheiten (100% Kontrolle). Die Qualitätsbeurteilungen müssen dann auf Basis von Stichproben geschehen. Hierzu werden dem Prozess in geeigneter, repräsentativer Weise Einheiten entnommen, an denen dann das Qualitätsniveau bezüglich eines oder mehrerer Qualitätsmerkmale bestimmt wird. Dabei können diese Bewertungen der Prozessqualität generell zwei Zielsetzungen verfolgen:

- Quantitative Bewertungen, d.h. Abschätzung des Qualitätsniveaus um Informationen über Lage, Variabilität und/oder Defektrate des Prozesses zu erlangen

- Qualitative Bewertungen, d.h. Entscheidung über das Qualitätsniveau als akzeptabel oder nicht verbunden mit definierten Annahme- und Ablehnregeln.

Verfahren der statistischen Annahmestichprobenprüfung („Statistical Acceptance Sampling“) als Spezialfall einer qualitativen Qualitätsbewertung, werden in vielen Untersuchungen der Wareneingangs- oder Warenausgangskontrolle verwendet. Diese Verfahren werden dabei oft in der finalen Freigabe- oder Endabnahmeprüfung genutzt. Das allgemeine Prinzip dieser Prüfungen lässt sich dabei wie folgt zusammenfassen:

- Einem zu untersuchenden Lot wird eine geeignete, repräsentative Stichprobe entnommen

- Anhand dieser Stichprobe wird die Lotqualität bewertet und mit vorgegebenen Standards bzw. Anforderungen verglichen

- Basierend auf diesen Ergebnissen fällt eine Entscheidung, ob das untersuchte Lot die Qualitätsanforderungen erfüllt und ob es daher angenommen werden kann oder ob es diese Qualitätsanforderungen nicht erfüllt und deshalb abzulehnen ist.

Seit mehr als 40 Jahren sind die Stichprobenpläne des Military Standards 105 beziehungsweise dessen nahezu unveränderte zivile Nachfolger ANSI Z.14, ISO 2859 und DIN ISO 2859 in diesem Zusammenhang das in der Industrie meistverbreitete System zur stichprobenbasierten Qualitätssicherung. In diesen Dokumenten werden konkret mehr als 1000 Stichprobenprozeduren zur Annahme bzw. Ablehnung von untersuchten Lots in Abhängigkeit vom geforderten Qualitätsniveau angegeben.

Quality Engineering – Zusammenfassung

In diesem Artikel wurden die wichtigsten statistischen Methoden im Umfeld des Quality Engineering im Laufe eines Prozesslebenszyklus nähergebracht und erläutert. Wir haben gezeigt, dass in Abhängigkeit von Vorinformation und Zielsetzung diese Verfahren eher deskriptiven, informativen oder aber qualitativ, bewertenden Charakter besitzen können. Darüber hinaus können die konkret angewendeten statistischen Methoden komplex und anspruchsvoll werden. Beispiele wären etwa eine multivariate statistische Prozesskontrolle oder eine Versuchsplanung mit Nebenbedingungen. Insbesondere die Interpretation der Ergebnisse und die Übertragbarkeit sind hier dann ein heikles und schwieriges Thema.

Weitere Quellen

ISO 9001 (2015) “Qualitätsmanagementsysteme – Anforderungen”

Ryan, T. P.: „Statistical Methods for Quality Improvement“

Schriftenreihe der A.I.A.G. (Automotive Industry Action Group: Chrysler Corporation, Ford Motor Company, General Motors Corp.)

Schriftenreihe „Technische Statistik“ der Bosch-Gruppe

ISO 2859-1 (2014) „Annahmestichprobenprüfung anhand der Anzahl fehlerhafter Einheiten oder Fehler (Attributprüfung) – Teil 1: Nach der annehmbaren Qualitätsgrenzlage (AQL) geordnete Stichprobenpläne für die Prüfung einer Serie von Losen“