Die Sensitivitätsanalyse beschreibt ein Konzept, das die Robustheit diagnostischer und prognostischer Modelle betrachtet. Insbesondere bei der Interpretation von Messgrössen wie dem Blutdruck gewinnt die Sensitivitätsanalyse zunehmend an Bedeutung.

Als Mediziner sind Sie täglich mit der Herausforderung konfrontiert, präzise Diagnosen stellen und fundierte Therapieentscheidungen treffen zu müssen. Doch wie verlässlich sind Ihre Schlussfolgerungen, wenn die zugrundeliegenden Messwerte oder die definierenden Grenzwerte geringfügigen Unsicherheiten oder Schwankungen unterliegen?

Sensitivitätsanalyse: besondere Bedeutung für die Blutdruckmessung

Insbesondere im Bereich der Blutdruckmessung ist die Sensitivitätsanalyse von besonderer Relevanz. Anders als bei vielen anderen diagnostischen Verfahren, die oft binäre Ergebnisse basierend auf einem spezifischen Biomarker-Nachweis liefern, also z. B. “krank” oder “nicht krank”, ist der Blutdruck eine kontinuierliche Messgrösse, deren exakte Werte und deren Einordnung in Diagnosekategorien entscheidend sind.

Es gibt kaum eine andere einzelne medizinische Massnahme, die so universell, häufig und über alle Fachrichtungen hinweg angewendet wird wie die Blutdruckmessung.

Fehlerpotential in der Blutdruckmessung

Die tägliche Variabilität des Blutdrucks, die unterschiedlichen Messmethoden wie dem Praxisblutdruck oder einer 24-Stunden-Messung, potenzielle Messfehler und die Festlegung von Diagnose-Cut-offs machen die Interpretation komplex. Kleinste Abweichungen in diesen Faktoren können immense Auswirkungen auf die korrekte Klassifikation eines Patienten haben, von der Unterschätzung einer Hypertonie bis zur Überdiagnose.

Die Sensitivitätsanalyse bei Blutdruckmessungen bietet Ihnen hier die notwendige methodische Klarheit, um potenzielle Fehlerquellen zu identifizieren und die Stabilität Ihrer diagnostischen Prozesse systematisch zu überprüfen.

Sensitivitätsanalyse in der Statistik – Unterstützung durch Novustat

Bei Novustat unterstützen wir Sie professionell bei der Durchführung und Interpretation Ihrer Sensitivitätsanalyse in der Statistik – von einfachen One-at-a-Time-Ansätzen (OAT) bis hin zu komplexen Global Sensitivity Analyses (GSA) mit Methoden wie Sobol-Indices, Morris-Verfahren oder Monte-Carlo-Simulationen.

Unsere Statistik-Experten arbeiten mit allen gängigen Tools: ob Excel, R, Python, SPSS oder spezialisierte Software wie MedCalc und SAS – wir passen uns Ihrer Infrastruktur und Fragestellung flexibel an. Lassen Sie Ihre Sensitivitätsanalyse von erfahrenen Statistikern durchführen – zur statistischen Beratung.

Warum die Sensitivitätsanalyse in der Medizin unverzichtbar ist: Umgang mit Unsicherheit und Variabilität

In der Medizin sind die Diagnosestellung und Therapieplanung untrennbar mit der Interpretation von Patientendaten verbunden. Bei der Blutdruckmessung ist die Präzision der Messwerte von entscheidender Bedeutung für die korrekte Diagnose einer Hypertonie und die Einleitung adäquater Behandlungsstrategien.

Allerdings unterliegen diese gemessenen Werte einer Vielzahl von intrinsischen und extrinsischen Variationsquellen, die die diagnostische Genauigkeit erheblich beeinflussen können.

Zu diesen Variabilitätsfaktoren zählen unter anderem:

- Physiologische Schwankungen: Der Blutdruck variiert physiologisch im Tagesverlauf (zirkadianer Rhythmus), in Abhängigkeit von körperlicher Aktivität, emotionalem Zustand (Weisskittelhypertonie) und der Nahrungsaufnahme.

- Messmethoden: Ob eine manuelle Auskultationsmethode, ein oszillometrisches automatisiertes Gerät in der Praxis oder eine 24-Stunden-Ambulante Blutdruckmessung (ABPM) verwendet wird. Jede Methode hat ihre spezifischen Eigenschaften und potenzielle Fehlerquellen.

- Messgerät und Kalibrierung: Die Genauigkeit der verwendeten Geräte und deren regelmässige Kalibrierung sind fundamental. Eine unzureichende Kalibrierung kann zu systematischen Messfehlern führen.

- Patientenfaktoren: Die korrekte Patientenlagerung, Manschettengrösse und -platzierung sowie der Aktivitätsstatus des Patienten vor und während der Messung sind entscheidend.

- Umgebungsfaktoren: Temperatur, Lärm und selbst die Atmosphäre im Behandlungszimmer können den Blutdruck beeinflussen.

Diese Variabilität kann zu falsch-positiven oder falsch-negativen Diagnosen führen. Eine falsch-positive Diagnose kann unnötige Behandlungen, Medikationsnebenwirkungen und psychische Belastungen für den Patienten zur Folge haben. Eine falsch-negative Diagnose hingegen verzögert notwendige Interventionen und erhöht das Risiko schwerwiegender kardiovaskulärer Ereignisse.

Die Sensitivitätsanalyse bietet hier einen systematischen Ansatz, um zu untersuchen, wie robust die diagnostische Sensitivität unter diesen Unsicherheiten bleibt. Sie ermöglicht es Ihnen, die Grenzen der Verlässlichkeit Ihrer Messungen zu verstehen und somit fundierte klinische Entscheidungen zu treffen.

Sensitivitätsanalyse Definition: Ein fundamentaler Begriff in der medizinischen Statistik

Die Definition der Sensitivitätsanalyse beschreibt im Kern eine systematische Methode zur Quantifizierung der Unsicherheit in den Ergebnissen eines Modells oder einer Schlussfolgerung, die aus der Unsicherheit in den Eingabeparametern dieses Modells resultiert.

Im Kontext der medizinischen Diagnostik wie der Blutdruckmessung, bedeutet dies, dass Sie untersuchen, wie sich Abweichungen bei gemessenen Werten, der Wahl der Diagnosegrenzwerte (Cut-offs) oder sogar unterschiedlichen Messmethoden auf die finale diagnostische Klassifikation, beispielsweise die Erkennung von Hypertonie, auswirken.

Der primäre Zweck der Sensitivitätsanalyse ist dabei:

- Robustheitsprüfung: Sie überprüft die Stabilität der Modellausgabe gegenüber Änderungen der Eingabeparameter. Bleibt die Diagnose auch dann korrekt, wenn der gemessene Blutdruck leicht schwankt oder der Grenzwert minimal angepasst wird?

- Identifikation kritischer Parameter: Sie hilft, jene Parameter zu identifizieren, die den grössten Einfluss auf das Ergebnis haben. Dies ist entscheidend, um die Messgenauigkeit auf die kritischsten Faktoren zu konzentrieren oder Empfehlungen für die Standardisierung von Messprozessen abzuleiten.

- Risikobewertung: Durch die Quantifizierung der Unsicherheit können potenzielle Risiken von Fehlklassifikationen besser eingeschätzt und kommuniziert werden.

- Modellvalidierung: Im Bereich der Sensitivitätsanalyse Statistik ist sie ein integraler Bestandteil der Modellvalidierung. Sie stellt sicher, dass ein Modell nicht nur auf spezifische Eingabewerte zugeschnitten ist, sondern auch unter variierenden Bedingungen stabile und plausible Ergebnisse liefert.

Die Sensitivitätsanalyse in der Blutdruckbestimmung erhöht damit die Transparenz und Nachvollziehbarkeit von Entscheidungsprozessen und führt zu einer verbesserten Patientensicherheit.

Sensitivitätsanalyse: Durchführung in der Blutdruckanalyse

Die Durchführung von Sensitivitätsanalysen bei der Blutdruckanalyse erfordert zunächst eine sorgfältige Auswahl der Methode. Die Komplexität des diagnostischen Modells, die Anzahl der zu variierenden Parameter und die gewünschte Tiefe der Analyse bestimmen den geeigneten Ansatz.

Im Kontext der Blutdruckmessung können die zu untersuchenden Parameter von physiologischen Schwankungen über Geräteungenauigkeiten bis hin zu unterschiedlichen Diagnosegrenzwerten reichen. Im Wesentlichen lassen sich zwei Hauptkategorien von Sensitivitätsanalysen unterscheiden, die jeweils spezifische Anwendungsgebiete und Implikationen für die Blutdruckanalyse haben.

Eine-Faktor-Analyse (One-at-a-Time, OAT) für erste Einschätzungen des Blutdrucks

Die Eine-Faktor-Analyse, oft als OAT-Analyse bezeichnet, ist die grundlegendste Form. Bei dieser Methode wird jeweils nur ein einzelner Eingabeparameter variiert, während alle anderen Parameter auf ihren Baselines oder Nominalwerten konstant gehalten werden. Die Auswirkungen dieser Variation auf die Modellausgabe, im Fall der Blutdruckanalyse beispielsweise die diagnostische Klassifikation (Hypertonie/Normotonie) oder die Sensitivität des Messverfahrens, werden dann beobachtet und dokumentiert.

Im Kontext der Blutdruckanalyse bedeutet dies:

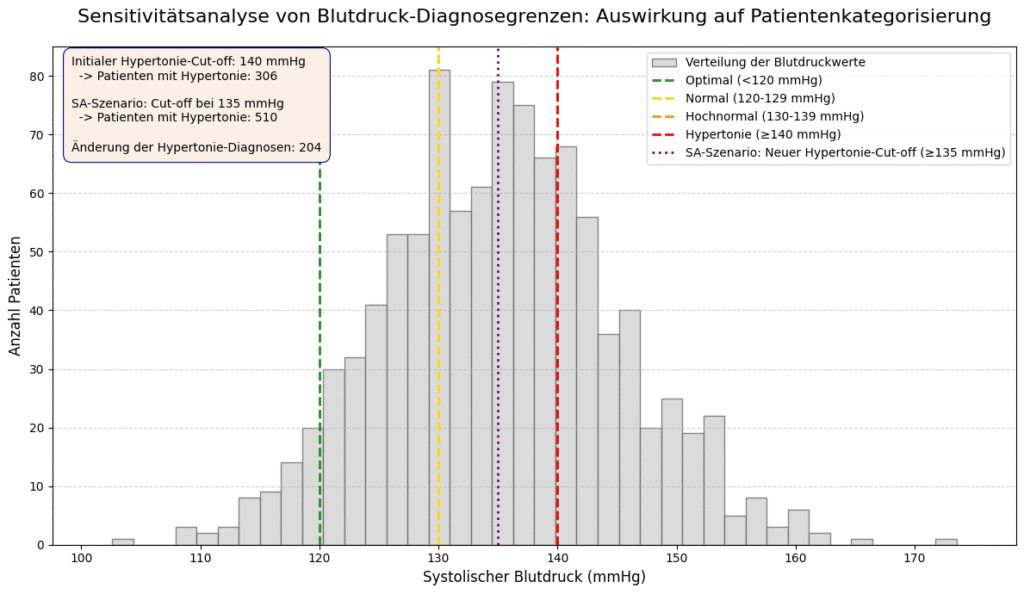

- Variieren des systolischen oder diastolischen Cut-off-Wertes, um zu sehen, wie sich die Anzahl der diagnostizierten Hypertoniker ändert.

- Simulation eines systematischen Messfehlers (+/- X mmHg) bei einer bestimmten Messmethode, während andere Faktoren konstant bleiben.

- Untersuchung des Einflusses einer veränderten Tageszeit der Messung auf die Sensitivität der Diagnose, angenommen alle anderen Bedingungen bleiben gleich.

Vor- und Nachteile der OAT-Analyse in der Blutdruckanalyse

| Vorteile | Nachteile |

|---|---|

| Einfachheit Leicht verständlich und durchführbar – auch mit Basiskenntnissen in Tools wie Excel. Ärzt*innen können erste Hypothesen eigenständig prüfen. | Ignorieren von Wechselwirkungen Wechselwirkungen zwischen Parametern bleiben unberücksichtigt – z. B. Tageszeit, Patiententyp oder Messfehler wirken in Kombination oft anders als isoliert. |

| Schnelle erste Einsichten Erlaubt eine rasche Identifikation von Parametern mit grossem Einfluss – etwa wenn eine Änderung des Grenzwerts um 5 mmHg deutliche Effekte zeigt. |

Globale Sensitivitätsanalyse (GSA) für umfassende Blutdruckmodelle

Im Gegensatz zur OAT-Analyse werden bei der Globalen Sensitivitätsanalyse (GSA) alle oder eine grosse Untergruppe von Eingabeparametern gleichzeitig variiert. Dies ermöglicht die Erfassung komplexer Interaktionen zwischen den Parametern und liefert ein umfassenderes Bild der Modellunsicherheit und der Parameterempfindlichkeit. Die GSA ist besonders relevant, wenn die Modellbeziehungen nicht-linear sind oder signifikante Interaktionen erwartet werden, was bei der Modellierung von Blutdruckdaten häufig der Fall ist.

Im Bereich der Blutdruckanalyse ist die GSA damit zu bevorzugen, um:

- Die kombinierte Wirkung von physiologischen Schwankungen, Messgeräteungenauigkeiten und patientenspezifischen Faktoren auf die Diagnose zu verstehen.

- Die Robustheit von Algorithmen zur automatisierten Blutdruckklassifikation unter realistischen Bedingungen zu testen.

- Die Auswirkungen verschiedener Implementierungen von Leitlinien (z.B. neue Cut-offs für alters- oder komorbiditätsspezifische Hypertoniedefinitionen) zu bewerten.

Methoden der Globalen Sensitivitätsanalyse umfassen

- Monte-Carlo-Simulationen: Hierbei werden die Eingabeparameter (z.B. der mittlere Blutdruck eines Patienten, die Varianz des Messfehlers des Geräts) zufällig innerhalb ihrer definierten Verteilungsbereiche variiert, und das Blutdruckmodell wird unzählige Male ausgeführt. Die resultierende Verteilung der diagnostischen Ergebnisse gibt Aufschluss über die Unsicherheit der Modellausgabe. Dies kann zum Beispiel die Bandbreite der möglichen Sensitivitäts- oder Spezifitätswerte unter verschiedenen Messbedingungen aufzeigen.

- Varianzbasierte Methoden (z.B. Sobol-Indizes, FAST): Diese Methoden sind hoch informativ für die Blutdruckanalyse. Sie quantifizieren den Beitrag jedes einzelnen Parameters (z.B. die individuelle Variabilität des Patientenblutdrucks) sowie die Beiträge von Interaktionen zwischen Parametern (z.B. wie der Messfehler eines Geräts mit der physiologischen Tag-Nacht-Variabilität des Patienten interagiert) zur Gesamtvarianz der Modellausgabe. Das ermöglicht die Identifikation der Treiber der Unsicherheit in der Blutdruckdiagnostik.

- Regression-basierte Methoden: Hier wird eine Regression zwischen den verschiedenen Eingabeparametern (z.B. Alter, Geschlecht, Messmethode, gemessener Wert) und der Modellausgabe (z.B. Wahrscheinlichkeit einer korrekten Hypertonie-Diagnose) durchgeführt, um die Sensitivität der Ausgaben gegenüber Änderungen der Eingaben zu schätzen.

Vor- und Nachteile der GSA in der Blutdruckanalyse

| Vorteile | Nachteile |

|---|---|

| Erfassung von Wechselwirkungen Berücksichtigt synergistische und antagonistische Effekte – z. B. Zusammenspiel von Messgenauigkeit, Tageszeit und Aktivitätslevel. | Komplexität Benötigt fortgeschrittene Methodenkenntnisse für Berechnung und Interpretation. |

| Umfassende Unsicherheitsquantifizierung Optimal für komplexe Modelle mit vielen Unsicherheiten – z. B. bei interindividuellen Unterschieden in der Blutdruckanalyse. | Rechenintensität Hoher Ressourcenbedarf und Einsatz spezialisierter Statistiksoftware erforderlich (z. B. R, MATLAB, Python). |

| Robustere Ergebnisse Lieferung verlässlicherer Erkenntnisse als OAT – besonders relevant für klinische Entscheidungen und Leitlinien. |

Die Wahl der richtigen Art der Sensitivitätsanalyse hängt massgeblich von der spezifischen Forschungsfrage, der Art der Blutdruckdaten und den verfügbaren Ressourcen ab. Für robuste und umfassende Analysen, die die vielfältigen Einflussfaktoren bei der Blutdruckmessung adäquat berücksichtigen, wird die Globale Sensitivitätsanalyse in kritischen medizinischen Kontexten bevorzugt. Sie ist entscheidend, um die tatsächliche Verlässlichkeit und Anwendbarkeit diagnostischer Blutdruckschwellen zu bewerten.

Übersicht: Sensitivitätsanalyse-Methoden und ihre Eignung für die Blutdruckanalyse

Folgende Tabelle bietet Ihnen eine detaillierte Übersicht über die gängigsten Sensitivitätsanalyse-Methoden und deren spezifische Eignung für Fragestellungen im Bereich der Blutdruckanalyse, inklusive der Art der benötigten Software und der typischen Ergebnisse.

Beispiel: Sensitivitätsanalyse der diagnostischen Sensitivität bei Blutdruckmessungen

Um die methodische Relevanz der Sensitivitätsanalyse in der klinischen Praxis zu verdeutlichen, wird nachfolgend ein Beispiel aus der kardiologischen Diagnostik herangezogen. Ziel ist die Bewertung der diagnostischen Sensitivität einer automatisierten Praxis-Blutdruckmessung (PBM) im Hinblick auf die Detektion von Hypertonie, wobei die 24-Stunden-Ambulante Blutdruckmessung (ABPM) als Referenzstandard (Goldstandard) fungiert.

Ausgangsdaten und Modellannahmen für die Analyse

Für diese Sensitivitätsanalyse wird eine hypothetische Kohorte von 1000 Patienten zugrunde gelegt, bei denen sowohl eine PBM als auch eine ABPM durchgeführt wurden. Die diagnostischen Kriterien sind wie folgt definiert:

- Referenzstandard (ABPM): Hypertonie wird als mittlerer 24h-Blutdruck von ≥130/80 mmHg definiert. Innerhalb der Kohorte erfüllen 400 Patienten dieses Kriterium der Hypertonie gemäss ABPM.

- Index-Test (PBM): Hypertonie wird basierend auf einem PBM-Wert von ≥140/90 mmHg diagnostiziert.

Ausgangsszenario: Diagnostische Klassifikation der PBM im Vergleich zur ABPM (Standard-Cut-offs)

| ABPM: Hypertonie (+) | ABPM: Normotonie (-) | Gesamt | |

| PBM: Hypertonie (+) (TP) | 320 | 80 (FP) | 400 |

| PBM: Normotonie (-) (FN) | 80 | 520 (TN) | 600 |

| Gesamt (PBM) | 400 | 600 | 1000 |

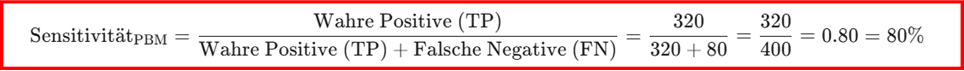

Basierend auf dieser Vierfeldertafel lässt sich die diagnostische Sensitivität der PBM unter den definierten Standardbedingungen berechnen. Die Sensitivität quantifiziert die Fähigkeit eines diagnostischen Tests, tatsächlich kranke Personen korrekt als krank zu identifizieren.

Sie wird ermittelt als der Quotient aus der Anzahl der wahren Positiven (TP), also Patienten, die sowohl nach dem Referenzstandard (ABPM) als auch nach dem Index-Test (PBM) als hypertensiv klassifiziert wurden, und der Gesamtzahl der nach dem Referenzstandard tatsächlich Kranken, der Summe aus wahren Positiven und falsch Negativen (FN). Falsch Negative sind in diesem Kontext Patienten, die gemäss ABPM hypertensiv sind, deren Zustand jedoch von der PBM nicht erkannt wurde.

Sensitivitätsanalyse Berechnung:

Die PBM weist in diesem Ausgangsszenario eine diagnostische Sensitivität von 80% auf. Dies impliziert, dass 80% der Patienten, die basierend auf der ABPM tatsächlich als hypertensiv gelten, von der Praxis-Blutdruckmessung korrekt identifiziert werden.

Sensitivitätsanalyse: Evaluierung des Einflusses von Messfehlern und Diagnosegrenzen

Im Rahmen der Sensitivitätsanalyse werden nachfolgend zwei kritische Parameter systematisch variiert: ein angenommener systematischer Messfehler der PBM und eine Anpassung des diagnostischen Cut-off-Wertes für die Hypertonie-Diagnose.

Szenario 1: Implementierung eines systematischen Messfehlers der PBM (+5 mmHg)

Es wird angenommen, dass das verwendete PBM-Gerät einen konstanten systematischen Bias von +5 mmHg aufweist. Dieser Bias könnte beispielsweise durch eine unzureichende Kalibrierung oder einen konsistenten “Weisskitteleffekt” bei allen Messungen resultieren. Die Sensitivitätsanalyse untersucht, wie diese systematische Abweichung die diagnostische Sensitivität beeinflusst.

Durch diesen systematischen Fehler werden PBM-Werte um 5 mmHg nach oben verschoben. Dies führt dazu, dass einige Patienten, deren ursprüngliche PBM-Werte knapp unterhalb des 140/90 mmHg Cut-offs lagen, nun diesen Schwellenwert überschreiten.

- Annahmen zur Anpassung der Klassifikation: Es wird angenommen, dass von den 80 ursprünglich falsch Negativen (ABPM-positiv, PBM-negativ) nun 40 Patienten durch den +5 mmHg Fehler korrekt als positiv klassifiziert werden.

- Parallel dazu wird angenommen, dass von den 520 ursprünglich wahren Negativen (ABPM-negativ, PBM-negativ) 60 Patienten fälschlicherweise als positiv eingestuft werden, da ihr PBM-Wert den Schwellenwert überschreitet. Die Gesamtanzahl der nach ABPM hypertensiven Patienten (400) und normotensiven Patienten (600) bleibt unverändert.

Sensitivitätswerte unter einem systematischen Messfehler von +5 mmHg (PBM)

| ABPM: Hypertonie (+) | ABPM: Normotonie (-) | Gesamt | |

| PBM: Hypertonie (+) (TP) | 360 | 140 (FP) | 500 |

| PBM: Normotonie (-) (FN) | 40 | 460 (TN) | 500 |

| Gesamt (PBM) | 400 | 600 | 1000 |

Die diagnostische Sensitivität im Szenario 1 berechnet sich wie folgt:

Sensitivitätsanalyse Berechnung:

Ein angenommener systematischer Messfehler von +5 mmHg führt in diesem Sensitivitätsanalyse Beispiel zu einer Erhöhung der diagnostischen Sensitivität der PBM auf 90%. Dieses Resultat demonstriert, dass selbst eine scheinbar geringfügige Messungenauigkeit erhebliche Auswirkungen auf die Fähigkeit eines Tests haben kann, tatsächliche Krankheitsfälle zu detektieren.

Es ist jedoch zu beachten, dass eine solche Erhöhung der Sensitivität häufig mit einem Anstieg der falsch-positiven Diagnosen einhergeht, was wiederum die Spezifität des Tests negativ beeinflusst.

Szenario 2: Anpassung des PBM-Cut-off auf 135/85 mmHg

In diesem Szenario wird die Auswirkung einer Reduktion des diagnostischen Schwellenwertes für Hypertonie bei der PBM analysiert, ohne die Annahme eines Messfehlers. Dies entspricht der Anwendung einer strengeren Definition von Hypertonie durch die PBM.

- Annahmen zur Anpassung der Klassifikation: Durch die Absenkung der diagnostischen Schwelle werden mehr Patienten, die tatsächlich hypertensiv sind (laut ABPM), aber im Ausgangsszenario unterhalb des ursprünglichen PBM-Cut-offs lagen, nun korrekt als positiv klassifiziert. Parallel dazu werden auch mehr normotensive Patienten (laut ABPM), deren Werte nahe am alten Cut-off lagen, nun als positiv eingestuft.

- Konkret wird angenommen, dass von den 80 ursprünglich falsch Negativen (ABPM-positiv, PBM-negativ) 50 Patienten durch den neuen, strengeren Cut-off nun korrekt als positiv erkannt werden. Gleichzeitig wird angenommen, dass von den 520 ursprünglich wahren Negativen (ABPM-negativ, PBM-negativ) 70 Patienten fälschlicherweise als positiv eingestuft werden, da ihr PBM-Wert den neuen, niedrigeren Schwellenwert überschreitet.

Sensitivitätswerte bei reduziertem PBM-Cut-off auf 135/85 mmHg

| ABPM: Hypertonie (+) | ABPM: Normotonie (-) | Gesamt | |

| PBM: Hypertonie (+) (TP) | 370 | 150 (FP) | 520 |

| PBM: Normotonie (-) (FN) | 30 | 450 (TN) | 480 |

| Gesamt (PBM) | 400 | 600 | 1000 |

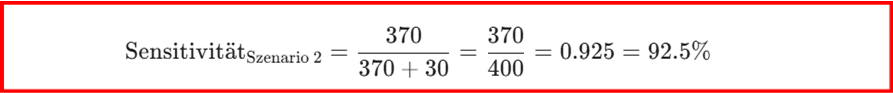

Die diagnostische Sensitivität im Szenario 2 beträgt:

Sensitivitätsanalyse Berechnung:

Die Reduktion des diagnostischen Cut-off-Wertes führt in diesem Szenario zu einer Erhöhung der diagnostischen Sensitivität der PBM auf 92.5%. Dieses Sensitivitätsanalyse Beispiel verdeutlicht eindringlich, dass die Wahl des diagnostischen Schwellenwertes einen signifikanten Einfluss auf die Performance eines Tests hat. Eine höhere Sensitivität bedeutet in diesem Kontext, dass weniger tatsächlich hypertensive Patienten übersehen werden, was aus klinischer Sicht oft wünschenswert ist. Allerdings kann eine solche Anpassung gleichzeitig die Gefahr von falsch-positiven Diagnosen erhöhen. Die Sensitivitätsanalyse ermöglicht es Ihnen als Mediziner, diese klinischen Abwägungen (trade-offs) quantifiziert zu verstehen und somit informierte Entscheidungen über die optimalen Diagnosekriterien zu treffen.

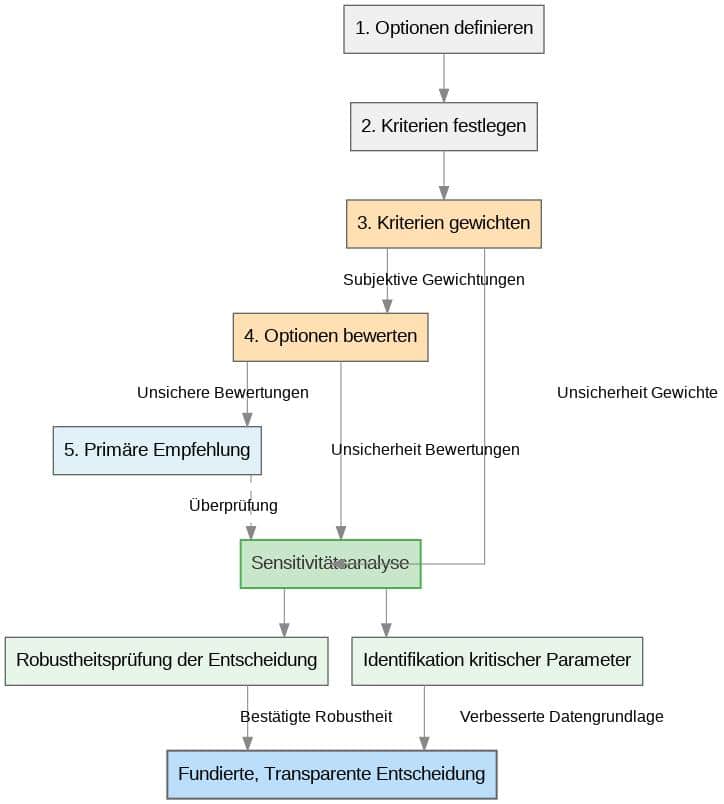

Sensitivitäts- und Nutzwertanalyse: Entscheidungsfindung im Blutdruckmanagement

Die Sensitivitätsanalyse ist in Kombination mit der Nutzwertanalyse entscheidend für die medizinische Entscheidungsfindung im Blutdruckmanagement.

Die Nutzwertanalyse ist eine multikriterielle Methode zur Bewertung von Therapieansätzen, Screening-Programmen oder Investitionen in Blutdruckmessgeräte anhand definierter Kriterien (z.B. Wirksamkeit, Nebenwirkungen, Kosten, Lebensqualität, Patientenpräferenz).

Problem: Gewichtungen und Bewertungen sind oft subjektiv oder unsicher. Hier setzt die Sensitivitätsanalyse an: Sie untersucht, wie robust die Rangfolge der Optionen gegenüber Änderungen dieser Annahmen ist.

Vorteile im Blutdruckmanagement

- Erhöhte Robustheit der Entscheidung: Stellt sicher, dass Therapieempfehlungen auch bei leicht geänderten Einschätzungen vorteilhaft bleiben.

- Transparenz & Nachvollziehbarkeit: Zeigt auf, welche Annahmen entscheidend sind und wo Unsicherheiten bestehen – wichtig für die Kommunikation.

- Identifizierung kritischer Parameter: Hilft, Faktoren zu erkennen, deren Unsicherheit den grössten Einfluss auf die Therapieentscheidung hat.

Die Integration der Sensitivitätsanalyse in die Nutzwertanalyse überprüft systematisch die Stabilität von Entscheidungen im Blutdruckmanagement gegenüber variierenden Präferenzen und Unsicherheiten. Dies führt zu fundierteren und robusteren Therapieentscheidungen im klinischen Umfeld.

Softwarelösungen für die Sensitivitätsanalyse der Blutdruckmessung

Die Wahl der geeigneten Software für die Sensitivitätsanalyse ist entscheidend für die Tiefe und Verlässlichkeit Ihrer Ergebnisse im Bereich der Blutdruckmessung. Während Sensitivitätsanalyse in Excel für grundlegende Analysen sehr nützlich ist, reichen ihre Kapazitäten für die Durchführung komplexer, globaler Sensitivitätsanalysen in grossen Datensätzen oder bei der Modellierung komplexer Wechselwirkungen oft nicht aus. Für diese anspruchsvolleren Aufgaben kommen spezialisierte Statistiksoftware und Programmiersprachen zum Einsatz.

Sensitivitätsanalyse der Blutdruckmessung in Excel

Microsoft Excel ist aufgrund seiner weiten Verbreitung und einfachen Bedienbarkeit oft das erste Werkzeug für grundlegende Sensitivitätsanalysen. Für die Blutdruckmessung kann Excel genutzt werden, um schnelle “Was-wäre-wenn”-Szenarien zu simulieren:

- Einfache Cut-off-Variationen: Sie können in Excel schnell die Auswirkungen unterschiedlicher Blutdruck-Schwellenwerte (z.B. von 140/90 mmHg auf 135/85 mmHg) auf die Anzahl der Hypertonie-Diagnosen in einem Datensatz simulieren. Dazu passen Sie einfach eine Zelle mit dem Grenzwert an und beobachten, wie sich die darauf basierenden Formeln (z.B. Zählfunktionen für “hyperton” oder “normoton”) ändern.

- Simulierte Messfehler: Es lassen sich einfache systematische Messfehler (z.B. alle Werte +5 mmHg) oder zufällige Messfehler (z.B. mittels Zufallszahlen und Standardabweichung) zu gemessenen Blutdruckwerten addieren und die daraus resultierenden Effekte auf diagnostische Klassifikationen oder Sensitivität/Spezifität (wenn Sie diese Formeln manuell in Excel hinterlegen) überprüfen.

- Szenario-Manager: Excel bietet einen integrierten “Szenario-Manager” (unter “Daten” > “Was-wäre-wenn-Analyse”), mit dem Sie verschiedene Parameterkombinationen speichern und schnell zwischen ihnen wechseln können, um die Auswirkungen auf die Blutdruckdiagnose zu vergleichen.

- Zielwertsuche: Hiermit können Sie ermitteln, welcher Eingabewert (z.B. ein Messfehler) erforderlich ist, um ein bestimmtes Ergebnis (z.B. eine Sensitivität von 90%) zu erreichen.

Grenzen von Excel für Blutdruck-Sensitivitätsanalysen

Excel stösst jedoch an seine Grenzen, wenn es um globale Sensitivitätsanalysen geht, die simultane Variationen mehrerer Parameter und die Analyse komplexer Interaktionen erfordern, z.B. wie sich Messfehler und Patientenvorerkrankungen und Tageszeit der Messung gleichzeitig auf die Diagnose auswirken.

Spezialisierte Software und Programmiersprachen für komplexe Sensitivitätsanalysen

Für anspruchsvollere Sensitivitätsanalysen im Bereich der Blutdruckmessung und darüber hinaus kommen folgende Tools zum Einsatz:

R mit spezialisierten Paketen

R ist eine freie Programmiersprache und Umgebung für statistische Berechnungen und Grafiken, die in der wissenschaftlichen Forschung und auch in der Medizin weit verbreitet ist. Für Sensitivitätsanalysen bietet R eine Fülle von spezialisierten Paketen, die über die einfachen “Was-wäre-wenn”-Analysen hinausgehen:

- sensitivity-Paket: Dieses Paket bietet Implementierungen verschiedener globaler Sensitivitätsmethoden, darunter Sobol-Indizes und den FAST (Fourier Amplitude Sensitivity Test). Diese Methoden sind in der Lage, den individuellen Beitrag jedes Eingabeparameters (z.B. Gerätekalibrierung, physiologische Variabilität) sowie die Beiträge von Interaktionen zwischen Parametern zur Gesamtvarianz der Modellausgabe (z.B. diagnostische Ungenauigkeit) zu quantifizieren. Dies ist entscheidend, um zu verstehen, welche Faktoren die Unsicherheit des Modells bei der Blutdruckdiagnostik am stärksten beeinflussen und wo die Anstrengungen zur Datenverbesserung am effektivsten wären.

- Monte-Carlo-Simulationen: Mit R können komplexe Monte-Carlo-Simulationen durchgeführt werden. Dabei werden Parameter, die bei der Blutdruckmessung Unsicherheiten aufweisen (z.B. altersbedingte Blutdruckvariabilität, Messfehlertoleranzen), aus ihren Wahrscheinlichkeitsverteilungen gezogen und Tausende von Modellläufen simuliert, um die Unsicherheit der diagnostischen Ergebnisse oder prognostischen Modelle zu bewerten.

Mehr erfahren: R Programmierung mit Novustat

Python mit spezialisierten Bibliotheken

Python ist eine weitere populäre Programmiersprache, die durch Bibliotheken wie SciPy, NumPy und insbesondere SALib (Sensitivity Analysis Library) leistungsstarke Tools für die Sensitivitätsanalyse bietet. Es ist flexibel und ermöglicht eine hohe Anpassbarkeit für spezifische medizinische Modelle.

Jetzt Unterstützung sichern: Python Statistik Beratung

Spezialisierte Statistiksoftware: z.B. MedCalc, SPSS, SAS

Kommerzielle Statistikprogramme wie MedCalc, SPSS oder SAS bieten ebenfalls leistungsstarke Funktionen für Sensitivitätsanalysen, insbesondere im Kontext klinischer Forschung und Diagnostik:

- ROC-Analyse (Receiver Operating Characteristic) und Diagnose-Tests: Programme wie MedCalc sind speziell auf die Analyse von ROC-Kurven und die Bewertung diagnostischer Tests wie z.B. die Unterscheidungskraft verschiedener Blutdruckmessmethoden spezialisiert. Sie ermöglichen die Berechnung und Sensitivitätsanalyse von Sensitivität, Spezifität, prädiktiven Werten und Likelihood Ratios und können oft auch die Auswirkungen von Cut-off-Variationen grafisch darstellen.

- Regressionsmodelle und Modellvalidierung: SPSS und SAS sind umfassende Statistikpakete, die für die Entwicklung komplexer Regressionsmodelle, also z.B. logistische Regression zur Vorhersage von Hypertonie-Risiken oder des Therapieansprechens basierend auf Blutdruckprofilen, und deren Validierung eingesetzt werden. Sie bieten Funktionen zur Überprüfung der Modellrobustheit gegenüber Veränderungen in den Prädiktoren oder Stichproben.

- Benutzerfreundlichkeit: Für Anwender, die keine tiefgehenden Programmierkenntnisse besitzen, bieten diese Programme oft eine grafische Benutzeroberfläche, die die Durchführung komplexer Analysen erleichtert.

Mehr dazu: SPSS Hilfe durch unsere Statistiker

Die Wahl der geeigneten Software hängt von der spezifischen Fragestellung, der Datenkomplexität und den vorhandenen Ressourcen ab. Für Mediziner, die über die grundlegenden Excel-Analysen hinausgehen möchten, sind R, Python oder spezialisierte Statistikpakete die Werkzeuge der Wahl, um robuste und tiefgehende Sensitivitätsanalysen durchzuführen und die Verlässlichkeit ihrer medizinischen Schlussfolgerungen zu untermauern.

Nachfolgende Tabelle vergleicht verbreitete Softwarelösungen hinsichtlich ihrer Eignung für Sensitivitätsanalysen im Bereich der Blutdruckmessung.

Vergleich der Softwarelösungen für Sensitivitätsanalysen in der Blutdruckmessung

| Software/Sprache | Stärken (für Blutdruck-SA) | Schwächen | Typische Anwendungsfälle (Blutdruck) | Kenntnisniveau | Kosten |

| Microsoft Excel | Einfachheit: Gut für schnelle, manuelle “Was-wäre-wenn”-Szenarien. Verbreitung: Nahezu jeder Mediziner hat Zugang. Grundlegende Simulationen: Cut-off-Variationen, einfache Messfehler. | Begrenzte Komplexität: Nicht für globale SA geeignet (keine Interaktionen). Manuelle Prozesse: Rechenintensiv für viele Szenarien. Fehleranfällig: Bei komplexen Formeln und Daten. | Schnelle Überprüfung von Diagnosegrenzen. Abschätzung der Auswirkungen eines einzelnen Messfehlers. | Anfänger | Teil von MS Office Lizenz |

| R (mit Paketen wie sensitivity) | Umfassend: Beste für globale Sensitivitätsanalysen (Sobol, FAST). Flexibel: Eigene Modelle und komplexe Simulationen. Reproduzierbar: Code-basiert. Spezialisierte Pakete: Für jedes Problem eine Lösung. Grafiken: Hochwertige Visualisierungen. | Einstiegshürde: Erfordert Programmierkenntnisse. Rechenintensiv: Für sehr grosse Simulationen. | Quantifizierung des Einflusses von Gerätegenauigkeit, Patientenvariabilität auf Diagnosegüte. Optimierung von Therapiealgorithmen unter Unsicherheit. | Fortgeschritten (Programmierung) | Kostenlos (Open Source) |

| Python (mit Bibliotheken wie SALib) | Sehr flexibel: Ähnlich wie R, breite Anwendung. Interoperabilität: Gut für Datenintegration. Reproduzierbar: Code-basiert. Maschinelles Lernen: Integration mit ML-Modellen zur Blutdruckvorhersage. | Einstiegshürde: Erfordert Programmierkenntnisse. Weniger medizin-spezifische Pakete als R (aber sehr flexibel). | Robuste Modellierung von Blutdruckverläufen. Sensitivitätsanalyse von KI-basierten Diagnosetools. | Fortgeschritten (Programmierung) | Kostenlos (Open Source) |

| MedCalc | Diagnose-Spezialist: Ausgezeichnet für ROC-Analyse, Sensitivität/Spezifität, prädiktive Werte. Benutzerfreundlich: Grafische Oberfläche. Medizin-fokussiert: Intuitive Benennungen und Auswertungen für Mediziner. | Weniger flexibel: Eher auf diagnostische Testbewertung spezialisiert, weniger für allgemeine globale SA. Kostenpflichtig. | Bewertung der diagnostischen Genauigkeit neuer Blutdruckmessgeräte. Vergleich verschiedener Blutdruckparameter (z.B. Zentraler vs. Brachialer BD). | Mittel (Software-Kenntnisse) | Kostenpflichtig |

| SPSS / SAS | Umfassend: Breite Palette statistischer Analysen (Regression, multivariate Modelle). Benutzerfreundlich (SPSS): Grafische Oberfläche. Hohe Performance (SAS): Für sehr grosse Datensätze. | Komplexität: Einarbeitungszeit kann lang sein. Kostenpflichtig: Hohe Lizenzgebühren. | Entwicklung von Regressionsmodellen zur Vorhersage von Hypertonie-Risiken. Validierung klinischer Leitlinien für Blutdruckbehandlung. | Mittel bis Fortgeschritten | Kostenpflichtig (hohe Lizenzgebühren) |

Fazit: Die Sensitivitätsanalyse ist bei der Blutdruckmessung ein Pfeiler robuster medizinischer Entscheidungen

Die Sensitivitätsanalyse zur Blutdruckbestimmung ist von elementarer Bedeutung zur Steigerung der Qualität und Verlässlichkeit Ihrer Untersuchungen. Sie ermöglicht es, die inhärente Unsicherheit in Daten, Messungen und diagnostischen Modellen transparent zu machen und somit fundiertere Entscheidungen zu treffen.

Durch konsequente Sensitivitätsanalysen untermauern Sie nicht nur die Verlässlichkeit Ihrer Blutdruckanalysen, sondern minimieren auch potenzielle Risiken von Fehlklassifikationen und ermöglichen erfolgreiche Behandlungen. Dies optimiert nachhaltig die Patientensicherheit und Effizienz Ihrer medizinischen Interventionen.

Wenn Sie Unterstützung bei der Konzeption, der Berechnung oder Interpretation Ihrer Sensitivitätsanalysen benötigen, stehen Ihnen unsere erfahrenen Statistik-Experten gerne zur Seite. Kontaktieren Sie uns für eine unverbindliche Beratung, um das volle Potenzial Ihrer medizinischen Daten zu erschliessen.